"2027년 최정점"…어떤 제품들이 뜰까[메모리 슈퍼사이클 온다②]

"HBM 가격 인하 우려 완화" 평가…성장 지속될 듯범용 D램 가치도 재조명…다양한 분야로 저변 넓혀낸드도 몸값 높아져…새로운 AI 수혜주로 급격한 부상

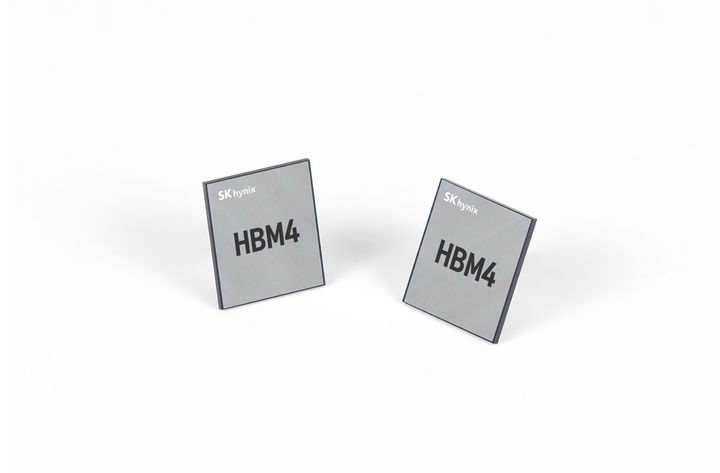

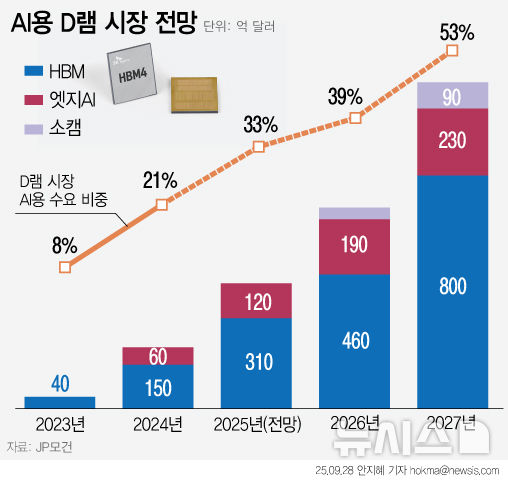

최근 급부상하고 있는 '메모리 슈퍼사이클(장기 호황)'의 특징은 메모리 전 제품의 '동반 성장' 가능성에 있다. 그동안 HBM(고대역폭메모리)이 '나홀로 성장'이었다면, 향후 수 년간은 범용 D램 시장이 거들고, 기업용 저장장치가 보태는 형국으로 국면이 바뀔 전망이다. 마치 '불꽃놀이'처럼 HBM의 폭발적 성장이 사방으로 퍼지며, 여러 형태로 재확산되는 장면이 기대된다. 28일 업계에 따르면 단기적으로 AI 데이터센터 구축을 위한 HBM의 지위는 굳건할 전망이다. HBM은 한 번 주고받을 수 있는 데이터 크기를 말하는 '대역폭' 기준으로 현존 최고다. 여러 개의 D램을 수직으로 쌓고 구멍을 뚫어 연결하는, 복잡하고 어려운 제조 방식이지만 아직 대안을 찾기 어렵다. 모건스탠리는 HBM 사용량이 올해 250억달러에서 2027년 530억달러로 2배 성장할 것으로 봤다. 그동안 삼성전자의 HBM 시장 진출로 가격 경쟁 가능성을 거론했는데, 이번에는 우려가 완화되고 있다는 평이다. JP모건도 HBM 시장 규모가 2027년 800억달러로, 올해(310억달러) 대비 2.5배 이상 성장할 것으로 예측했다. ◆HBM에서 범용 D램으로 '확대'…추론용 AI 개막 이런 가운데 'AI용 메모리' 제품군은 갈수록 다양화하고 있다. 추론용 '엣지 AI' 시대가 열리고 있어서다. 엣지 AI는 데이터를 클라우드나 중앙 서버로 보내지 않고, 스마트폰이나 카메라, 센서 등 현장에서 바로 처리해 분석하는 기술이다. 개인용 온디바이스 AI에서 산업 현장까지 더 확장된 개념이다. 그동안 AI 투자는 AI 모델 학습을 위해 대규모 AI 데이터센터를 만드는 데 집중돼 왔다. 하지만 이제 AI로 공정 자동화를 통해 스마트 공장을 만들고, 실시간 이상 징후를 감지하는 스마트 CCTV도 속속 도입되고 있다. 이런 환경은 중앙 서버로 데이터를 보내고 결과 값을 받는 과정에 비효율이 생기고, 에너지 낭비로 이어질 수 있다. 특히 산업 기밀문서나 개인 정보 유출에 대한 우려도 잇따른다. 그래서 실시간으로 데이터를 효율적으로 처리하는 방식이 선호된다. HBM 같은 고성능 메모리보다, 서버용 DDR5이나 그래픽용 GDDR7 등 범용 D램만으로도 시스템을 최적화할 수 있다.

◆엔비디아도 범용 메모리 재평가…AI 메모리 다극화 이런 제품은 기술 문턱이 낮아, 수익성도 떨어진다. 하지만 범용성을 무기 삼아 AI 데이터센터 외에 산업 설비, 스마트 시티, 사물인터넷(IoT), 자율주행차 등 다양한 분야에 응용할 수 있다. 범용 D램 경쟁력이 다시 한번 조명받는 것이다. 이런 엣지 AI용 메모리 시장은 현재 120억달러에서 오는 2027년 230억달러 규모로 성장할 전망이다. 특히 친환경 기술로도 각광 받는다. AI는 '전기 먹는 하마'라고 부를 정도로, 전력 소모가 극심하다. 이를 극복하기 위해 시스템을 효율적으로 운영하는 것이 중요한 데, 범용 D램이 그 역할을 맡을 수 있다. 무엇보다 AI 가속기 시장을 주도하는 엔비디아가 범용 D램을 적극 활용할 태세다. 엔비디아는 중국 수출용 GPU(그래픽처리장치)나 초대규모 컨텍스트 AI 추론에 특화된 차세대 '루빈 CPX' GPU에 GDDR7을 사용한다. 비용 효율적인 데이터 처리도 모색하고 있다. 나아가 새로운 형태의 메모리도 적극 개발 중이다. 엔비디아는 AI 서버의 효율적인 운영을 위해 CPU(중앙처리장치)에 저전력 D램을 활용하며, 차세대 '베라(Vera)' CPU에는 자체 설계한 '소캠(SoCamm)'을 도입하기로 했다. 이 제품은 HBM만큼은 아니지만, 데이터가 오가는 통로(대역폭)를 늘려 병목 현상을 줄이면서 동시에 LPDDR5X를 기반으로 전력 효율을 극대화한다. 소캠 시장은 내년 말부터 본격화해 2027년 90억달러 시장으로 커질 전망이다.

◆낸드도 '아픈 손가락' 종지부…AI 수혜주 된다 낸드 플래시 메모리 역시 새로운 조류를 타고 더 나은 가능성을 향해 가고 있다. 낸드 시장은 수요 예측이 어렵고, 업체 수가 많아 고난이 예상된다. 하지만 기업용 제품을 중심으로 AI 수혜주로 급격히 부상하고 있다. 특히 대용량이면서 동시에 고성능, 고효율 QLC(쿼드러블레벨셀) 기술이 도입된 기업용 솔리드스테이트드라이브(eSSD)를 사용하는 AI 데이터센터가 늘고 있다. 여전히 전통적인 데이터 저장장치인 HDD(하드디스크드라이브)와 가성비 경쟁이 불가피하다. 다만 최근 HDD 시장에서 납품 기한이 1년 이상 장기화하는 문제로 인해 SSD 시장은 더욱 주목받고 있다. 이는 모건스탠리가 삼성전자나 SK하이닉스 외에 키오시아, 샌디스크 등 낸드 전문 업체의 '비중 확대'를 제시한 근거이기도 하다. SK하이닉스와 샌디스크는 미래 스토리지 기술인 고대역폭플래시메모리(HBF)를 적극 개발한다는 입장이다. 이 제품은 HBM처럼 셀을 수직으로 쌓고, 데이터 I/O(입출구 통로) 수를 늘려 대용량 저장 데이터를 빠르게 처리하는 기술이다. 일본 낸드 업체 키오시아도 엔비디아와 차세대 AI 서버용 초고속 SSD를 공동 개발 중이다. 이는 추론용 AI 시대를 맞아, HBM의 새로운 '파트너'가 될 수 있다. ◎공감언론 뉴시스 [email protected] |